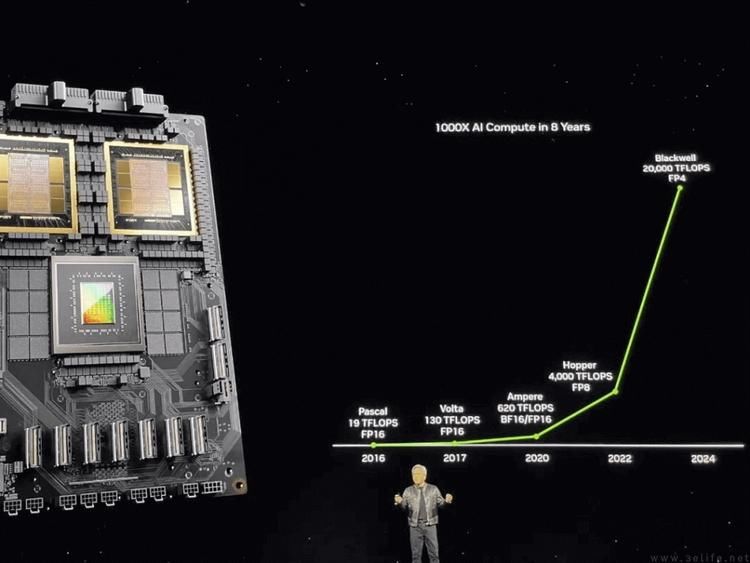

2024年3月底,NVIDIA方面在GTC大会上宣布了旗下首款“2024年度旗舰”GPU产品——Blackwell架构的B200。

NVIDIA B200家族,史上最强AI处理器诞生

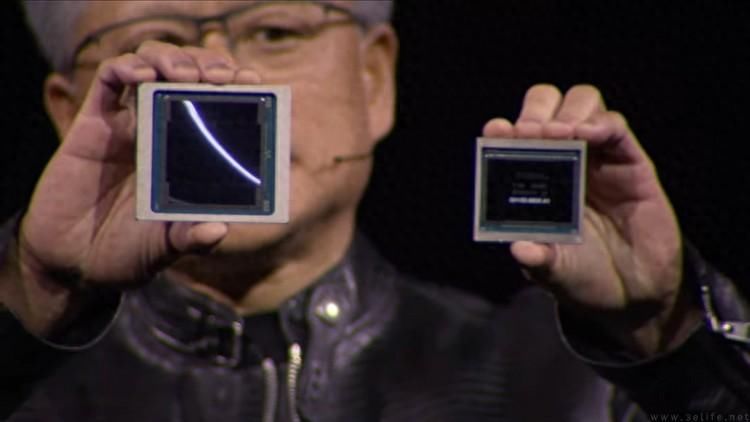

根据NVIDIA公布的参数显示,B200本质上是一款“原生双芯”设计的GPU芯片。它的每一个芯片内含两个Die,两个Die之间则通过10TB/s带宽的NV-HBI总线互联,可以做到完全无延迟的算力融合,因此可以“等同于”一颗2080亿晶体管的超大GPU设计,同时降低制造难度、提高良品率。

与此同时,在B200 GPU内部,每个Die拥有四颗24GB的HBM3e显存堆叠,总计容量192GB,等效显存带宽更是高达8TB/s。

根据NVIDIA的说法,专为AI训练优化的B200现在在FP8浮点格式下的AI运算性能可以高达20PFlops。如果采用专为新架构设计的FP4浮点格式,那么它的实际运算速度还能再上涨一倍、来到40PFlops。

这是什么概念呢?对比前代的H100 AI芯片,B200的性能可以达到它的2.5(FP8格式)到5(FP4格式)倍之多。如果与一般PC上使用的RTX4090 GPU相比,B200的AI性能甚至可以达到后者(1.3PFlops)的15.3倍,同时功耗仅有RTX4090的2.5倍左右。

换句话说,从AI计算的能效比而言,即便只采用FP8的“老格式”进行运算,B200的AI能效比也达到了RTX4090的6倍以上。

这还没完,因为B200还有多种“扩展形态”。其中包括但不限于由两颗B200 GPU与一颗NVIDIA Grace CPU组成的“GB200”超级芯片、由8颗B200与一颗x86 CPU组成的服务器节点方案HGX B200,以及基于B200修改而来、可直接兼容现有H100服务器基础设施(接口、主板)的B100,还有基于B100实现的HGX B100节点方案等等。

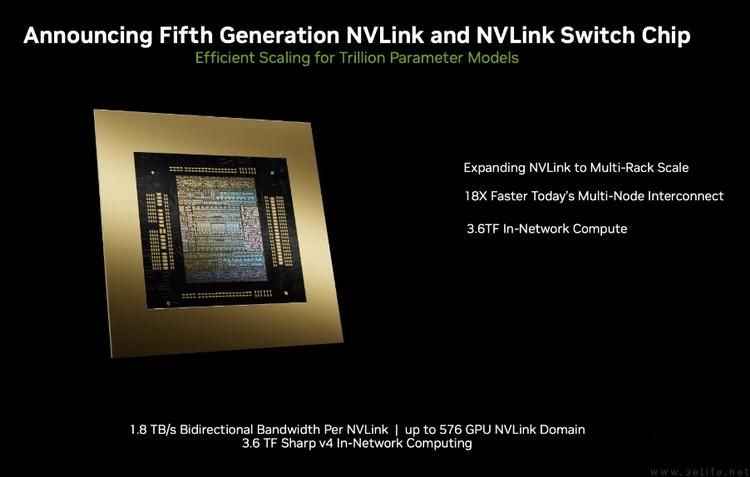

最后,NVIDIA方面还宣布了服务于新GPU的第五代NVLink互联控制器,它可提供高达1.8TB/s的实时双向带宽,是前一代H100芯片所能提供的互联带宽的18倍。顺带一提,这也相当于消费级市场现存最后一代量产NVLink方案(RTX3090Ti,112.5GB/s)的16倍之多。

个人开发者买不到B200?但是我们有AWS

当然大家都知道,无论B200、GB200,还是HGX B200或HGX B100,它们都不是给“一般玩家”使用的设备。即便是对于个人AI开发者或者小型的AI相关企业来说,想要真正买上一套基于B200的AI超算,至少目前来说还是困难重重的。

但这是否意味着,普通的AI开发者就没有办法享受到“业界最强AI处理器”的红利了呢?

当然不是。因为只要有看过NVIDIA这次发布会的朋友就会知道,在此次公布的合作伙伴名单里,排名在第一位就是公有云服务提供商AWS、也就是亚马逊云科技。

根据AWS方面公布的相关信息表明,他们将能够提供多种不同的、基于NVIDIA Blackwell新架构的AI云计算实例。其中既包括“顶配”的GB200 NVL72,即配有72个Blackwell GPU和36个Grace CPU、通过NVLink互联的计算节点,还包括未来将在EC2 UltraCluster中提供的新型B100 GPU实例。

除此之外,AWS还将与NVIDIA共同运营NVIDIA DGX Cloud、一个基于AWS的AI设计平台,开发者可以很简单地通过它,访问和部署生成超大型AI模型所需的基础设施和软件。根据目前公布的技术资料显示,它所支持的参数数量最多可以超过1万亿个。要知道,目前很多消费级的云端大模型都还没超过1000亿参数量级,所以AWS提供的这个新服务和算力,已经足够许多厂商再发展好几代大模型了。

AWS Nitro网络,让超级AI算力更加安全

说到大模型的训练,除了足够高的算力之外,训练过程中的安全性显然也是至关重要的一环。作为早在2011年就推出了全球首个GPU云实例的云计算厂商,AWS自然早已为相关需求做足了准备。

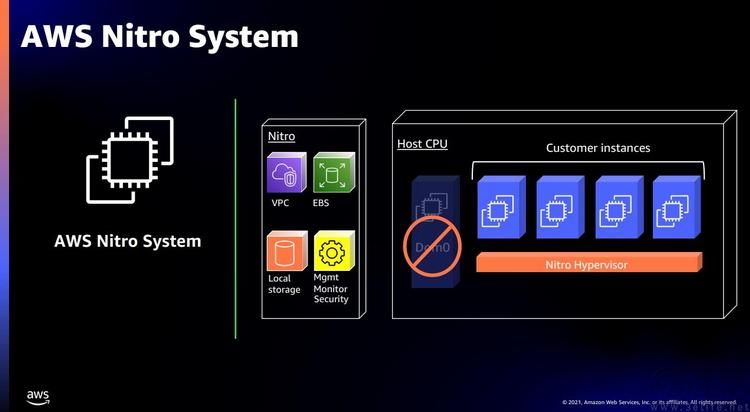

众所周知,AWS拥有自研的网络加速和安全系统、也就是久负盛名的AWS Nitro。当它与全新的NVIDIA GB200结合起来使用的时候,就可以带来多重的性能与安全收益。

一方面,AWS Nitro的专用硬件可以独立处理系统IO负载,这样一来,相关计算量就会从GB200的CPU和GPU上“转移”掉,从而进一步释放性能,让更多的算力可以真正被客户使用,而不是消耗在网络数据包的管理上。

另一方面,AWS Nitro可以提供增强的数据安全传输保护,它能够确保代码的完整性,同时对客户侧和AWS侧都进行加密,确保每一次训练指令和操作不会受到外部攻击的影响。并且这种端到端的安全特性已经通过了网络安全公司NCC Group的独立验证,以实际证明其有效性。

不仅如此,AWS还允许客户通过AWS Nitro Enclaves和AWS KMS创建可信的执行环境,加密训练数据和权重数据。特别值得一提的是,在AWS里,这种加密数据可以在硬件层面与GB200芯片直接内部通信,而不受外部实例的影响。

这样一来,即便是企业里的AWS操作员,也不可能在实例层面对数据包进行解密操作。如此以来,训练过程将可以得到更高层级的保密防护,有效确保了他们的潜在商业利益和技术独特性。

事实上,就连NVIDIA自己也是AWS的“忠实用户”

在今年的GTC上,NVIDIA创始人兼首席执行官黄仁勋就曾表示,“人工智能正在以前所未有的速度推动突破,带来新的应用程序、商业模式和跨行业创新。我们与AWS的合作正在加速新的生成式人工智能功能,并为客户提供前所未有的服务,突破可能界限的计算能力。”

不过他当时并没有说明的、更有趣的一个事实是,即便NVIDIA自己,实际上也在依赖AWS的能力来实现“自我进化”。

这指的便是NVIDIA和AWS的合作项目Project Ceiba。这套托管在AWS的“云端超算”如今配备了20736个B200 GPU,以及10368个NVIDIA Grace CPU,而负责如此巨大的计算集群连接的,就是AWS引以为傲的第四代Elastic Fabric Adapter (EFA) 网络设备。它为每一颗GB200提供了高达800Gbps的网络带宽,从而充分保证了高达414EXAFlops的海量AI吞吐量。

对于NVIDIA来说,他们将使用这庞大的算力来推进图像、视频生成、机器人、自动驾驶、气候预测等领域的前沿AI技术。换言之,当游戏玩家或者PC爱好者通过他们的NVIDIA驱动更新接收到最新的游戏AI画质算法更新,或者当各大汽车厂商拿到最新的自动驾驶算法更新时,这背后可能都有AWS的“默默奉献”在里面。

友情提示

本站部分转载文章,皆来自互联网,仅供参考及分享,并不用于任何商业用途;版权归原作者所有,如涉及作品内容、版权和其他问题,请与本网联系,我们将在第一时间删除内容!

联系邮箱:1042463605@qq.com