如果你的大脑可以模拟,会发生什么?

半月谈记者 张漫子

人工智能的战场,是算法之争、数据之争,更是算力之争。AI烧热的,不只是一个个街谈巷议的话题,更是一颗颗大模型须臾不可离的GPU。

算力焦虑,犹如人工智能头顶的一朵乌云。吹散这朵乌云,能仅凭传统芯片不断升级的力量吗?也许,我们应该换个思路,转而向我们自己的大脑学习……

要论能效,还看大脑

1946年,世界上第一台电脑诞生。1973年,世界上第一台手机接通。经过半个多世纪的发展,今天的电脑手机已经成为人们追求智能生活不可或缺的基础设施。只不过,若论能效——算力与所需能量消耗之比,它们与人脑相比还是略逊一筹。

不妨用数字说话。训练一款ChatGPT,需要烧掉多少算力?如Open AI所透露的,ChatGPT背后有一个庞大的计算网络——Azure AI超算平台。这个微软专门建设的高性能网络集群包含1万颗GPU,为ChatGPT付出的总算力消耗超过3640 PF-days(以每秒计算1000万亿次计,持续计算3640天)。

而人类大脑在25瓦的极低能耗下,就能实现复杂环境中的关联记忆、快速识别、自主学习。这是为什么呢?

人类大脑活动是精密而连续的动力学过程,复杂程度远超当前算力资源模拟的上限。大脑约有1000亿个神经元,100万亿个突触,突触连接的平均长度约10-1000微米。以记忆为例,就与突触形态与功能的长期变化有关。

清华大学集成电路学院长聘副教授高滨举了一个例子:生理学先驱巴甫洛夫每天在狗吃饭前敲响铃声,再给它食物。经过一段时间,狗只要听到铃声,第一反应就是分泌唾液。这是因为狗的大脑已经在摇铃铛和吃东西之间建起连接,微观层面而言,就是两个神经元之间的突触连接变强,记忆由是产生,在此基础上,完成一次自适应学习。

小小芯片,模拟大脑

与人类大脑不同,迄今计算机的计算体系结构采取冯·诺依曼架构,计算与存储分离。数据在处理器和存储器之间不停地来回传输,约80%至90%的功耗都消耗在“搬运”中。

“每运算一次,就相当于把贮藏在遥远仓库(存储器)中的原材料(数据)运输到相距甚远的加工厂(处理器),而且运输的道路很是狭窄。这就导致实际生产效率非常低下,生产能力受到了运输能力的限制——这个局限就是‘存储墙’。运算量越大,这个瓶颈就越显著。”高滨说,冯·诺依曼架构在进行大规模的矩阵运算时,局限更为明显。

试想一下,人类大脑在思考时会有计算和存储的分别吗?左半球计算、右半球存储?“不是的。大脑的计算、存储发生在同一处,无需把数据搬来搬去。”中国科学院微电子研究所研究员尚大山说。

让我们重新回到人脑的工作原理。神经元接收来自其他神经元的信号,达到一定阈值时,即会向其他神经元发送信号。突触则负责信号传递,而且会依据信号的强度调整传递的强度(突触权重)。这个看似简单无奇的过程,却是身为“万物灵长”的人类智慧得以承传的前提,学习与记忆发生的基础。

简洁、高效而灵活,这样的计算方式让芯片科学家感慨演化的神奇之余,也不禁设想:何不设计一种可以模拟人脑的芯片?

一种新型电路元件——忆阻器,使这一设想有了实现的可能。

尚大山将忆阻器比作一条流动的河流:“河流的宽度(电阻值)可以根据流过的水量(电荷)而变化。如果流过更多的水,河床可能会变宽,使后续的水流更容易通过(电阻减小)。即使水流停止(断电),河流的宽度(忆阻器的电阻状态)也不会变化,直到有新的水流来改变它。”

为何说忆阻器能够模拟大脑?高滨说,忆阻器的奇妙特性,就在于可以通过外加电压的调制来改变其电阻值,这样,忆阻器器件就可理解为一个“电子突触”,突触权重用忆阻器电阻值来模拟。忆阻器阵列就可模拟人脑神经元的突触连接;神经元的功能,则可以搭建具体的功能电路模拟。当前人工智能的核心算法——深度神经网络,就转化为了忆阻器阵列的模拟计算。

简单说,忆阻器存算一体芯片是存储器中实现计算。“这相当于将加工厂放到了仓库边上,做到了本地加工生产,把交通运输过程中的时间、能源耗费降到最低。”高滨说。

超越“摩尔”,有待时日

衡量信息技术进步速度的摩尔定律,大家也许都耳熟能详。不过,在一颗芯片上已可集成800亿个晶体管的今天,这一“定律”还能适用多久,业界不无忧心。为芯片革新寻求增加晶体管数量之外的可能,在追求更高性能的同时尽量满足低功耗、低延迟、低成本,成为当务之急。

打破“存储墙”的存算一体模式,成为超越摩尔定律的潜在方向。而忆阻器,某种程度上就是存算一体的未来。

img src="http://p9.img.360kuai.com/t01104fb45610bea5fc.jpg">

img src="http://p9.img.360kuai.com/t01104fb45610bea5fc.jpg">

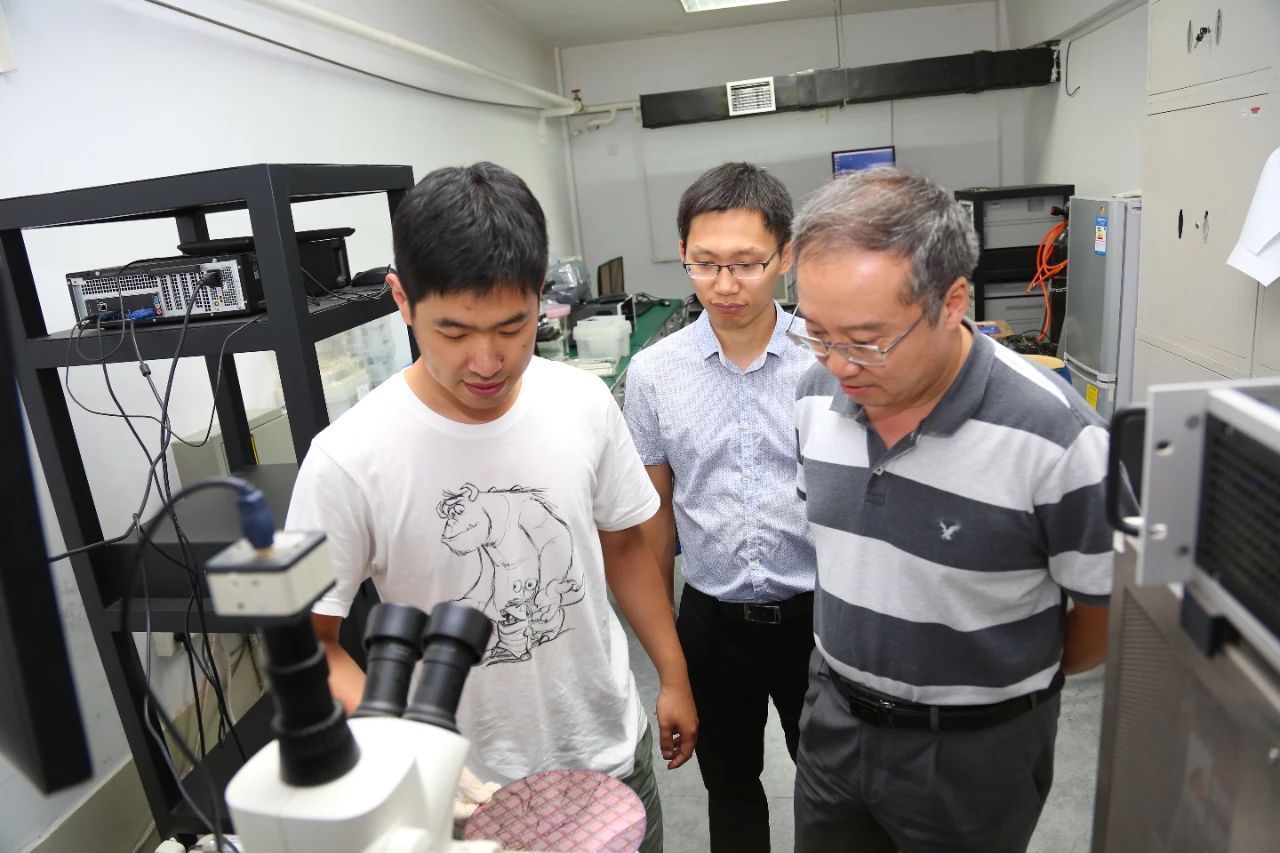

清华大学研究人员在实验室进行忆阻器电学特性实验

“忆阻器存算一体芯片最大的优势在于能效高,有望比冯·诺依曼架构提升2至3个数量级,是弥补工艺制程代差的可选路径。”中国移动研究院物联网研究所副所长牛亚文说,近期清华大学联合中国移动研发的110纳米忆阻器存算一体芯片已经达到冯·诺依曼架构28纳米GPU的能效。

访问密集型任务尤其是这种新型芯片的用武之地。人脸识别、图像识别、语义分割、大数据检索……种种人工智能时代的寻常场景,都可让忆阻器高密度和非挥发性存储的特性一展长才。

当然,当前忆阻器存算一体芯片仍存在集成规模受限、推理精度误差大、软件生态构建难等问题,将硬件、软件、系统、算法、库以及终端应用一体化整合,还有很长一段路要走。有专家提醒,忆阻器芯片一个有待突破的局限在于其耐久性。传统存储芯片依恃的晶体管靠控制电子的移动来存储数据,而忆阻器控制的是离子的移动。离子较电子更重,时间一长,灵活性、耐久性不免打了折扣。

芯片研发是需要在产业化中不断淬厉的事业。从科学到工程,从实验室到生产线,忆阻器芯片可以期待的明天,还在业界不断尝试的努力之中。

友情提示

本站部分转载文章,皆来自互联网,仅供参考及分享,并不用于任何商业用途;版权归原作者所有,如涉及作品内容、版权和其他问题,请与本网联系,我们将在第一时间删除内容!

联系邮箱:1042463605@qq.com