作者 | 陈斯达

编辑 | 邓咏仪

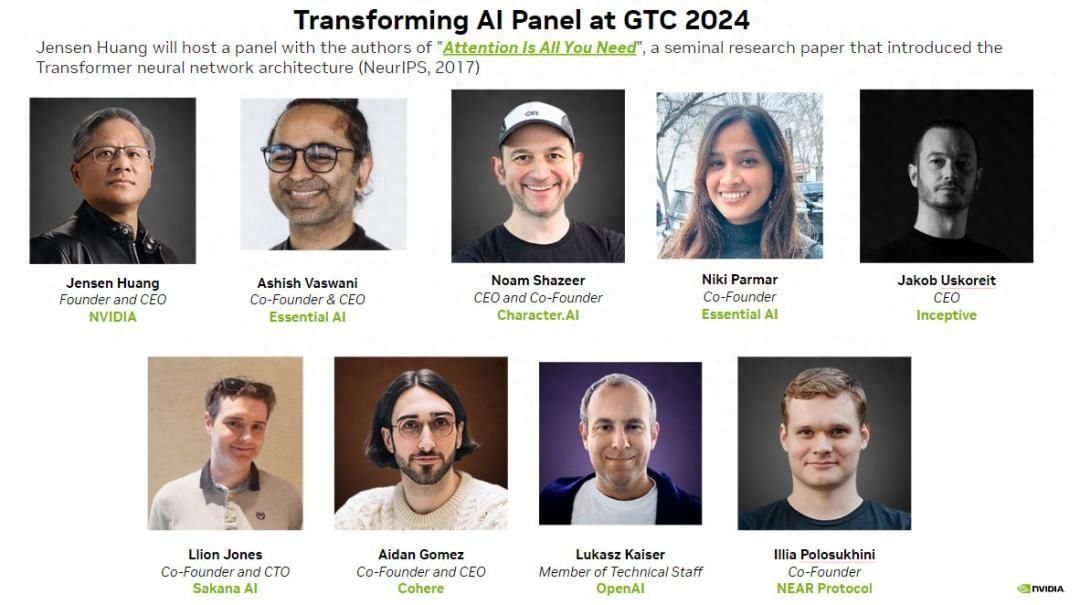

英伟达的万众瞩目GTC大会第三天,黄仁勋又憋出一个大招——集齐“Transformer七子”,来一场圆桌讨论。

这场对谈让观众们回到AI浪潮“梦开始的地方”——2017年,谷歌大脑团队发表了一篇名为Attention is all you need 的论文,其中所提出的Transformer架构,为当下大热的ChatGPT、Gemini等大模型打下基础,人工智能领域从此变天。论文的八位作者,也被称为“Transformer八子”。

不过,八位作者后来也陆续离开谷歌。除Lukasz Kaiser留在OpenAI外,其他几位作者都选择离开创业,他们创立的很多公司,也成为这一波浪潮中的当红炸子鸡。

“Transformer 八子”分别是:

Ashish Vaswani,EssentialAI 联合创始人兼 CEO

Noam Shazeer,Character.AI 首席执行官兼联合创始人

Jakob Uszkoreit,Inceptive 联合创始人兼首席执行官

Llion Jones,SakanaAI 联合创始人兼首席技术官

Aidan Gomez,Cohere 联合创始人兼首席执行官

Lukasz Kaiser,OpenAI 技术人员

Illia Polosukhin,NEAR Protocol 联合创始人

Niki Parmar,EssentialAI 联合创始人(因家庭原因未出席)

来源:GTC 2024

除了其中一位作者因家庭原因未能出席,其余几位都现身对话现场。能凑齐“七龙珠”,也显示出如今如日中天的英伟达排面有多大。

同时,这也是一场关键的产业对话——算力是大模型的核心燃料。此次AI浪潮中,英伟达作为供应商,又极大受益于大模型激增的算力需求。

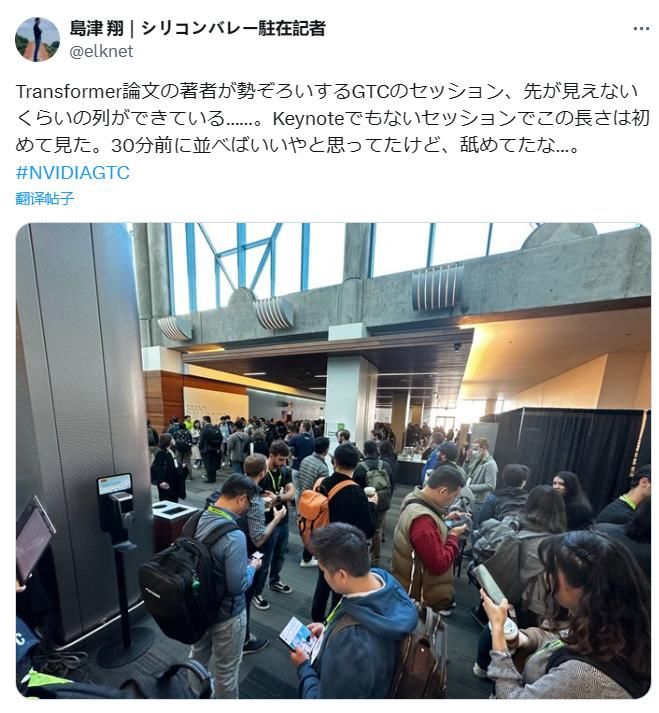

对谈开始前,观众排长队入场,图源:X

一小时里,作者们不仅回溯了Transformer的诞生,对模型技术发展的问题和未来路径的看法,也直戳要害:

目前基于Transformer的主流模型,基础架构和论文刚发表时进步不多

动用万亿参数资源进行简单计算会带来浪费,关注自适应计算才能高效分配计算资源

当前模型太实惠,规模还太小,一美元百万token比买本书的成本便宜得多

让更多人用上模型,使其不断交互才能变得聪明,待在实验室里并不会造福世界

推理是下一个重要的进步节点,能提升数据训练效率,产生更有价值的结果

Illia Polosukhin:如果要做出能真正读取搜索结果的模型,比如做到处理成堆的文档,当时的递归神经网络(RNN)并不能满足这样庞大的信息处理需求。

Noam Shazeer:团队开始探讨用卷积或者注意力机制来取代它。蒸汽机也能实现工业革命,但Transformer就像内燃机让一切变得更加高效。而随着模型规模的增大,智能程度也随之提高。只是在预测下一个token,它就会变得如此聪明,够做一百万个不同的事情。只要想办法扩大规模,就能让它变得更好。

Ashish Vaswani:那些可以扩展的通用架构最终将在长期中胜出。今天的 token 是明天计算机行动的体现,它们开始模仿我们的活动,并自动化我们的工作。Transformer 自我注意,并使梯度下降变得更快。这是一种重复的主题,每次我们创建规则样本时都会体现。

Llion Jones:我想出了「Attention Is All You Need」这个标题。我们当时还在尝试做一些切除工作,尝试扔掉模型的一部分,令我们惊讶的是,甚至在扔掉所有的卷积的时候,模型会变得更好。

Transformer命名来由Jakob Uszkoreit:我们喜欢这个名字。模型使用了这样一种逻辑,改变了数据生产模式。所有的机器学习都是Transformer,都是颠覆者。

Noam Shazeer:我之前觉得这个名字过于简单,但很多人喜欢。我之前想过很多的名字,比如Yaakov,最终确定了“Transformer”。名字描述了模型的原理,因为它实际上转换了整个信号,按照这个逻辑,几乎所有的机器学习都会被转换。

Llion Jones:我们确实意识到,正在尝试创建一种非常通用的方法。它确实可以让任何东西之间相互转化。我们当时并未预测到这将会有多么成功。它是如此有趣,以至于我们可以将图像翻译成文本,将文本翻译成图像,翻译文本到文本。

Jakob Uszkoreit:在生物学研究的应用中,我们可以将其称为生物软件。起初是一个程序,然后编译成可以在 GPU 上运行的形式。基本上,生物软件的生命始于对特定行为规范的需求,比如在细胞中生成大量特定蛋白质,然后通过深度学习将其转译成 RNA 分子。但实际上,一旦进入细胞,就会表现出这些行为。所以,这个概念不仅是英语翻译成计算机代码还涉及到药物的规范,即完全转化为实际的分子药物。

需要有超越Transformer的东西Aidan Gomez:在推理方面,已经做了很多工作加速模型的进化,但又与我们先前的形式非常相似。我认为世界需要比Transformer更好的东西。我觉得现在与六七年前的情况相似。

Llion Jones:我认为需要有明显的进步。如果只是稍微改进,那还不足以让整个人工智能行业转向新局面。所以尽管原始模型可能不是现在可拥有的最强大的东西,但我们仍然固守在原来的模型上。

Jakob Uszkoreit:现在浪费了很多计算资源。我们更关注计算资源分配的问题,而非一味扩大资源总量。我们不希望在一个容易的问题上花太多资源,也不想看到在一个太难的问题上花的资源过少,而得不到解决方案。

Illiya Polosukhin:就像2+2,如果输入到模型,就会使用一万亿个参数。所以自适应计算是接下来必须出现的。我们要关注,在特定问题上具体要花费多少计算资源。

为何离开谷歌 & 以后想做什么?Ashish Vaswani(Essential AI):我们真的想理解并复制人类的认知目标,而不是简单模仿他们在做什么,因为这最终将改变我们与计算机交互以及工作的方式。我离开的一个主要原因是,让这些模型变得更聪明的唯一方式,就是把它们放到人们手中。不可能在实验室中让模型变得更聪明。你必须让它们走向世界,让世界与这些模型互动,从中获取反馈,并让它们变得更聪明。

Noam Shazeer(Character.AI):我离职时,心里最大的挫败感就是,令人难以置信的技术,还无法触及每个人。而它有如此多的用途,如此简单易用。我们的最终目标是帮助全世界每个人。所以我必须离职创业,让这些发生。

Jakob Uszkoreit(Inceptive):我更多意识到,这项技术能比以前更广泛地改善人们的生活质量。我的第一个孩子在疫情期间出生,这让我重新认识到生命的脆弱性。几周后,用于蛋白质结构预测的AlphaFold 2用于蛋白质结构预测的结果公布,Alpha Fold 2比1的一个重大变化是使用了transformer架构来取代其他模型架构,因此它在分子生物学领域可以投入使用。再过几周,mRNA COVID疫苗的功效结果公布,RNA尤其是RNA世界假说的潜力变得非常明确——用RNA就能完成生命中的任何事情,但长期以来数据一直很少,在某种程度上它是分子生物学领域的”遗孤”。所以这几乎成为了一种道德义务,必须有人去做。

Llion Jones(Sakana AI):我是最后一个离开谷歌的。目前我还处于非常早期的阶段。我试图向加入的研究人员灌输的核心理念是,学习总是对的。任何时候,如果你尝试从人工处理某事转向让计算机自己搜索最优解,你总是会赢的。事实上,最初的深度学习革命就是一个例子,我们不再进行人工特征工程,而是直接学习,效果好多了。所以我想提醒大家,有了大量计算资源后,我们除了在狭义的意义上训练大型语言模型外,还可以利用它来探索当前手工工程的搜索空间。

Aidan Gomez(Cohere):我认为这项技术能够改变世界。但现实中一切都没有改变,面对的是停滞状态,存在着技术发展与现实世界之间的差异,对我们这些了解内情的人来说是一种不协调感。所以我希望能够弥合这一差距。我们创建了一个平台,让每个企业都可以采用和集成这项技术到他们的产品中,而不是直接面向消费者。但这是我们想要推广该技术、让它更容易获取、更便宜且更有竞争力的方式。

Lukasz Kaiser(OpenAI):我最终加入了OpenAI。当我加入时,OpenAI正是拥有最好的Transformer模型的地方。在那家公司,我们知道可以利用大量数据和计算资源创造出优秀的东西。我当时还抱有一个希望,即使没有大量数据,只要有更多计算资源就行。

Illia Polosukhin(NEAR Protocol):我们正在从事的一项工作就是,创造一种全新的方式,让人们为超酷的模型贡献数据。它在区块链领域拥有全球最多的用户,有数百万的日活跃用户,他们甚至都不知道自己在使用区块链。但他们正在与这种可编程货币价值进行交互。现在我们开始利用它来重新构建一些工具,以生成更多数据。虽然在这可能是有争议的,但70年代的版权技术需要改变,我们正迎来一个新的生成时代。目前我们奖励创作者的方式已经被打破。唯一的解决方案是利用可编程货币、可编程价值和区块链。

推理是下一个重要的发展方向Llion Jones:推理是下一个重要的发展方向。很多人已经意识到了这一点,并且正在致力于研究。但是目前很多工作都是手工设计的,我们在手工编写提示信息,然后尝试让它们以我们认为合适的方式进行交互。当然,我们实际上应该搜索这个领域,学习如何将它们连接起来,打造出我们想要的功能强大的模型。

Jakob Uszkoreit:我们希望模型生成的内容能够符合人类的消费需求。这些模型应该接受我们喜欢或可以接受的所有刺激作为训练数据。因此,任何类型的视频、音频、任何观察世界的方式所获得的信息,包括时序信息,都应被纳入训练数据中。

Lukasz Kaiser:如果你有一个能够进行推理的模型,然后你只需要一点点数据。它就会进行一系列的推理,从中产生结果。由此,就能够从更少的数据中进行泛化,因为它在推理过程中进行了大量计算。当我们弄清楚了这一切,就将极大地减少数量。但数据的质量也会变得更加重要。

友情提示

本站部分转载文章,皆来自互联网,仅供参考及分享,并不用于任何商业用途;版权归原作者所有,如涉及作品内容、版权和其他问题,请与本网联系,我们将在第一时间删除内容!

联系邮箱:1042463605@qq.com